Korelacija v statistiki: definicija, vrste in merila povezanosti

Korelacija v statistiki: jasna definicija, vrste in merila povezanosti. Naučite se razlikovati pozitivno/negativno korelacijo ter izbrati pravo merilo za analizo.

V statistiki in teoriji verjetnosti korelacija pomeni, kako tesno sta povezana dva niza podatkov. Korelacija meri usmerjenost in jakost zveze med spremenljivkama, vendar sama po sebi še ne pove nič o vzročnosti.

Definicija in osnovne lastnosti

Korelacija opisuje, ali se spremembe v eni spremenljivki ujemajo s spremembami v drugi spremenljivki in v katero smer. Glavne lastnosti korelacijskega koeficienta (npr. Pearsonovega r) so:

- vrednost je običajno med -1 in +1;

- +1 pomeni popolno pozitivno linearno zvezo (oba naraščata skupaj);

- -1 pomeni popolno negativno linearno zvezo (ena narašča, druga pada);

- 0 pomeni, da ni linearne zveze — lahko pa obstaja ne-linerna zveza.

Smeri in moč korelacije

Smer korelacije je določena s predznakom koeficienta (+ ali -). Moč korelacije opisuje, kako tesna je zveza: majhna, zmerna ali močna. Pogoste omejne smernice za Pearsonov r (Cohenove smernice) so približno:

- |r| ≈ 0.1: majhen učinek;

- |r| ≈ 0.3: zmeren;

- |r| ≥ 0.5: velik (močan) učinek.

Te meje so zgolj smernice — njihovo smiselnost je odvisna od konteksta in raziskovalnega področja.

Merila povezanosti (pogosti koeficienti)

Za različne vrste podatkov in razmer se uporabljajo različna merila:

- Pearsonov korelacijski koeficient (r) — meri linearno zvezo med dvema količinskima (intervalnima/razmerjnimi) spremenljivkama. Primer izračuna: r = Σ(xi - x̄)(yi - ȳ) / sqrt[Σ(xi - x̄)² Σ(yi - ȳ)²]. Predpostavlja linearnost, normalnost in občutljiv je na odmaknjene vrednosti (outlierje).

- Spearmanov rang koeficient (ρ) — neparametrično merilo, ki temelji na rangih. Uporaben za monotone (ne nujno linearne) povezave ali kadar podatki niso normalno porazdeljeni.

- Kendallov tau — še eno rangovno merilo, robustno in uporabno pri majhnih vzorcih ali številnih vezanih rangih.

- Phi koeficient — za dve binarni (dvočleni) spremenljivki.

- Cramér's V — za nominalne spremenljivke z več kot dvema kategorijama (na primer križna tabela).

- Point-biserial — za povezavo med eno binarno in eno količinsko spremenljivko.

- Polychorični/Polyserial koeficienti — za predpostavko latentne neprekinjene spremenljivke, ki se meri z ordinalnimi kategorijami.

- Delna korelacija — meri zvezo med dvema spremenljivkama ob kontroliranju učinka ene ali več drugih spremenljivk.

- Avtokorelacija in križna korelacija — uporabljeni pri časovnih vrstah za merjenje povezanosti iste spremenljivke (z zamikom) ali med dvema časovnima vrstama.

Interpretacija in statistično testiranje

Poleg vrednosti korelacijskega koeficienta je pomembno poročanje o:

- velikosti vzorca (n) — majhni vzorci lahko dajejo nezanesljive ocene;

- statistični značilnosti (p-vrednost) — pri Pearsonovem r se pogosto uporablja t-test z df = n - 2, vendar p-vrednosti niso vse, kar šteje;

- intervalih zaupanja — pri oceni korelacije je priporočljivo navesti 95% interval zaupanja (Fisher-jeva z-transformacija je pogosto uporabljena za izračun CI).

Pomembno: korelacija ni vzročnost. Dva spremenljivka lahko korigirata zaradi tretjega dejavnika (konfounded), naključja ali sezonskih vzorcev. Primer: povezanost med prodajo sladoleda in številom utopitev je posledica skupnega dejavnika — temperature (poletje).

Predpostavke, pasti in kako se jim izogniti

- Outlierji lahko močno vplivajo na Pearsonov r — preverite grafično razporeditev podatkov;

- Ne-linearnost — močna nelinearna zveza lahko daje r blizu 0; v takih primerih uporabite graf ali transformacijo (npr. log), ali neparametrične koeficiente;

- Heteroskedastičnost (spremenljiva varianca) lahko ogrozi interpretacijo in statistično testiranje;

- Omejen razpon vrednosti (range restriction) znižuje opaženo korelacijo;

- Mere napake in nezanesljive meritve slabšajo opazovan r.

Vizualizacija in praktični nasveti

Vedno si oglejte podatke grafično. Na primer:

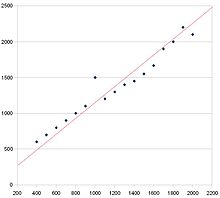

- na grafu razpršitve (scatterplot) narišite točke in črto najbolje prilegajoče se regresije, da vidite smer in morebitne odstopajoče točke;

- uporabite matriko korelacij in heatmap za več spremenljivk hkrati;

- poročajte korelacijo skupaj z n, p-vrednostjo in intervalom zaupanja;

- če obstaja sum na zamisljen vzrok, razmislite o načinu zbiranja podatkov (eksperimentalni dizajn, kontrola spremenljivk) ali o metodah za oceno vzročnosti (npr. regresija s kontrolami, instrumentalne spremenljivke).

Kratek primer

Če merimo višino in težo skupine ljudi, bomo običajno dobili pozitivno korelacijo (višji ljudje imajo pogosto večjo težo). Pearsonov r bi lahko bil npr. približno 0.6 — to pomeni zmerno do močno pozitivno linearno zvezo. Kljub temu ta korelacija ne pomeni, da višina povzroča težo ali obratno — gre za opis statistične zveze.

Za pravilno uporabo korelacij: preverite predpostavke, poročajte dodatne informacije (n, p, CI), in vedno prikažite podatke grafično — to prepreči napačne zaključke in razkrije skrite vzorce.

Ta razpršeni graf ima pozitivno korelacijo. To lahko ugotovite, ker je trend usmerjen navzgor in desno. Rdeča črta je črta najboljšega ujemanja.

Razlaga korelacije

Močna in šibka sta besedi, s katerima opisujemo korelacijo. Če je korelacija močna, so vse točke blizu skupaj. Če je korelacija šibka, so točke razporejene narazen. Obstajajo načini, kako s številkami prikazati, kako močna je korelacija. Te meritve se imenujejo korelacijski koeficienti. Najbolj znan je Pearsonov korelacijski koeficient produkt-moment. Podatke vnesete v formulo, ki vam da številko. Če je število 1 ali -1, potem je korelacija močna. Če je odgovor 0, korelacije ni. Druga vrsta korelacijskega koeficienta je Spearmanov korelacijski koeficient ranga.

Korelacija proti vzročnosti

Povezanost ne pomeni vedno, da ena stvar povzroča drugo stvar (vzročnost), saj je lahko oboje povzročilo kaj drugega. Na primer, v vročih dneh ljudje kupujejo sladoled, obenem pa hodijo na plažo, kjer nekatere pojedo morski psi. Med prodajo sladoleda in napadi morskih psov obstaja korelacija (v tem primeru se oboje zvišuje z naraščanjem temperature). Vendar to, da se prodaja sladoleda poveča, še ne pomeni, da prodaja sladoleda povzroča več napadov morskih psov ali obratno.

Ker korelacija ne pomeni vzročne zveze, znanstveniki, ekonomisti itd. preizkušajo svoje teorije z ustvarjanjem izoliranih okolij, v katerih se spreminja samo en dejavnik (če je to mogoče). Vendar pa politiki, prodajalci, novinarji in drugi pogosto namigujejo, da določena korelacija pomeni vzročno zvezo. To je lahko posledica neznanja ali želje po prepričevanju. Tako lahko novica pritegne pozornost z navedbo, da imajo ljudje, ki pogosteje uživajo določen izdelek, določene zdravstvene težave, kar pomeni vzročno zvezo, ki je lahko v resnici posledica nečesa drugega.

Sorodne strani

- Cohen, J., Cohen P., West, S.G., & Aiken, L.S. (2003). Applied multiple regression/correlation analysis for the behavioral sciences (Uporabna večkratna regresijska/korelacijska analiza za vedenjske vede). (Hillsdale, NJ: Lawrence Erlbaum Associates.

Vprašanja in odgovori

V: Kaj je korelacija?

O: Korelacija je način, kako tesno sta povezana dva niza podatkov.

V: Ali korelacija pomeni, da en niz podatkov povzroča drugega?

O: Ne, korelacija ne pomeni vedno, da en niz podatkov povzroča drugega. Dejansko je pogosto vpleten še tretji dejavnik.

V: Kateri sta dve smeri korelacije?

O: Dve smeri korelacije sta pozitivna in negativna.

V: Kaj pomeni pozitivna korelacija?

O: Pozitivna korelacija pomeni, da se oba niza podatkov skupaj povečujeta.

V: Kaj pomeni negativna korelacija?

O: Negativna korelacija pomeni, da en niz podatkov narašča, medtem ko drugi pada.

V: Ali obstajajo različne meritve korelacije?

O: Da, v različnih situacijah se uporablja veliko različnih meritev korelacije.

V: Kako ljudje pogosto prikažejo smer korelacije na grafu razpršitve?

O: Za prikaz smeri korelacije na grafu razpršitve ljudje pogosto narišejo črto najboljšega ujemanja.

Iskati