Linearna regresija: definicija, metode in praktične uporabe

Linearna regresija: definicija, ključne metode (najmanjši kvadrati, ridge) in praktične uporabe za napovedovanje, analizo ter izbiro spremenljivk.

Linearna regresija je način za pojasnitev razmerja med odvisno spremenljivko in eno ali več pojasnjevalnimi spremenljivkami z uporabo premice. Je poseben primer regresijske analize.

Linearna regresija je bila prva vrsta regresijske analize, ki je bila natančno preučena. To pa zato, ker je modele, ki so linearno odvisni od svojih neznanih parametrov, lažje prilagoditi kot modele, ki so nelinearno povezani s svojimi parametri. Poleg tega je lažje določiti statistične lastnosti dobljenih ocenjevalcev.

Linearna regresija ima veliko praktičnih uporab. Večina aplikacij spada v eno od naslednjih dveh širših kategorij:

- Linearno regresijo lahko uporabimo za prileganje napovednega modela na niz opazovanih vrednosti (podatkov). To je koristno, če je cilj napovedovanje, napovedovanje ali zmanjšanje. Če je po oblikovanju takšnega modela podana dodatna vrednost X brez spremljajoče vrednosti y, se lahko vgrajeni model uporabi za napovedovanje vrednosti y.

- Ob spremenljivki y in več spremenljivkah X1, ..., Xp, ki so lahko povezane z y, se lahko linearna regresijska analiza uporabi za količinsko opredelitev moči povezave med y in Xj, za oceno, katera Xj sploh ni povezana z y, in za določitev, katere podmnožice Xj vsebujejo odvečne informacije o y.

Pri linearnih regresijskih modelih se poskuša doseči, da je navpična razdalja med premico in podatkovnimi točkami (npr. ostanki) čim manjša. To imenujemo "prilagajanje premice podatkom". Linearni regresijski modeli pogosto poskušajo čim bolj zmanjšati vsoto kvadratov ostankov (najmanjši kvadrati), vendar obstajajo tudi drugi načini prilagajanja. Ti vključujejo minimiziranje "pomanjkanja ujemanja" v neki drugi normi (kot pri regresiji z najmanjšimi absolutnimi odstopanji) ali minimiziranje kaznovane različice funkcije izgube najmanjših kvadratov, kot pri regresiji z grebeni. Pristop najmanjših kvadratov se lahko uporabi tudi za prilagajanje modelov, ki niso linearni. Kot je opisano zgoraj, sta izraza "najmanjši kvadrati" in "linearni model" tesno povezana, vendar nista sopomenki.

Osnovne oblike in razlaga

Najpreprostejša oblika linearne regresije je enostavna linearna regresija s samo eno pojasnjevalno spremenljivko X in odvisno spremenljivko Y; model ima obliko Y = β0 + β1·X + ε. Pri več spremenljivkah gre za večkratno (multivariatno) linearno regresijo: Y = β0 + β1·X1 + ... + βp·Xp + ε. Ko so koeficienti β določeni, model napoveduje povprečno vrednost Y za dano kombinacijo vrednosti napovednikov.

Ocenjevanje parametrov

- Metoda najmanjših kvadratov (OLS): najpogostejša metoda; iščemo parametre, ki minimizirajo vsoto kvadratov ostankov. V matriki obliki je rešitev pogosto zapisana kot β = (X'X)^{-1} X'Y (če je X'X obrnljiv).

- Lastnosti OLS: pod klasičnimi predpostavkami OLS daje nepristranske (unbiased) ocene, z najnižjo varianco med vsemi linearno nepristranskimi ocenjevalci (Gauss–Markovova izreka, torej OLS je BLUE).

- Alternativne metode: najmanjši absolutni odstopki (LAD), robustne metode (Huberjeva izguba), in regularizacijske metode (npr. grebeni (ridge), LASSO, elastic net), ki so uporabne pri šumu, odstopanjih in visoki dimenzionalnosti.

Klasične predpostavke modela

Da bi bili rezultati interpretabilni in statistične metode veljavne, običajno predpostavljamo:

- linearnost razmerja med spremenljivkami in parametri;

- neodvisnost ostankov (ni avtokorelacije);

- homoscedastičnost (konstantna varianca ostankov);

- normalnost ostankov (za inferenco in intervale zaupanja, vsaj približno);

- manj ali obvladljiva multikolinearnost med napovedniki (prevelika korelacija povzroča nezanesljive ocene).

Če predpostavke ne držijo, moramo uporabiti transformacije, robustne metode, modeliranje odvisnosti ali prilagoditi ocenjevalne tehnike (npr. HAC standardne napake, ponderirane LS, regresija z grebeni ipd.).

Interpretacija in diagnostika

- Koeficienti β pokažejo pričakovano spremembo v Y ob enotski spremembi v Xi, ob fiksnih drugih spremenljivkah. Intercept (β0) je pričakovana vrednost Y, ko so vsi X = 0 (smiselnost odvisna od konteksta).

- R2 in popravljeni R2 merita, koliko variance Y pojasni model. R2 raste z dodajanjem spremenljivk, zato je za primerjavo modelov s različnim številom napovednikov bolj primeren popravljeni R2.

- Statistični testi: t-test za posamezen koeficient, F-test za celoten model, p-vrednosti in intervali zaupanja pomagajo oceniti pomembnost spremenljivk.

- Preverjanje ostankov: grafi ostankov proti napovedim pomenijo test homoscedastičnosti; QQ-plot ali Shapiro-Wilk za normalnost; testi heteroscedastičnosti (npr. Breusch–Pagan); indeksi vpliva (Cookova razdalja, leverage) za odvisne točke.

- Multikolinearnost: preveri se z VIF (variance inflation factor); visoki VIF pomenijo nezanesljive ocene in velike standardne napake.

Razširitve in praktične tehnike

- Regularizacija: ridge (grebeni) zmanjšuje velikost koeficientov z L2 kaznijo; LASSO z L1 kaznijo lahko izvede tudi izbiranje spremenljivk.

- Polinomska in interakcijska regresija: vključevanje polinomskih členov ali interakcij omogoči modeliranje ukrivljenih odnosov oziroma odvisnosti med napovedniki.

- Kodiranje kategoričnih spremenljivk: dummy (indikatorke) ali efektno kodiranje omogoča vključitev nominalnih spremenljivk v linearni model.

- Transformacije: log, kvadratni koren, Box–Cox ipd. se uporabljajo za stabilizacijo variance in linearizacijo odnosa.

- Cross-validation: preverjanje napovedne sposobnosti z navzkrižno validacijo preprečuje prenaučenje in pomaga pri izbiri hiperparametrov (npr. penalizacije).

Praktične uporabe

Linearna regresija je osnovno orodje na številnih področjih:

- ekonomija (napovedovanje potrošnje, cen, analiza vpliva spremenljivk),

- medicina (relacija med odmerkom in učinkom, analiza dejavnikov tveganja),

- okoljske vede (razlaga temperature glede na dejavnike),

- inženiring in proizvodnja (kontrola kakovosti, napovedovanje napak),

- strojnoučenje (hitri baseline modeli, interpretabilnost koeficientov).

Opozorila in dobre prakse

- avoiding napačne interpretacije: korelacija ni vzročnost — linearna regresija sama po sebi ne dokazuje vzročnosti;

- nevarnost prenaučenja pri velikem številu napovednikov glede na število opazovanj — uporaba regularizacije ali selekcije spremenljivk;

- previdnost pri ekstrapolaciji izven območja podatkov — napovedi so zunanji in nezanesljivi;

- pred obravnavo modela vedno preverite kakovost podatkov, manjkajoče vrednosti, merjenje in enote spremenljivk;

- standardizacija ali centriranje spremenljivk pogosto olajša interpretacijo in numerično stabilnost, še posebej pri regularizaciji.

Linearna regresija je močno, razumljivo in hitro orodje, primerno tako za osnovno analizo kot tudi za uvod v kompleksnejše metode. Njena pravilna uporaba zahteva pozornost pri preverjanju predpostavk, diagnozi in interpretaciji rezultatov.

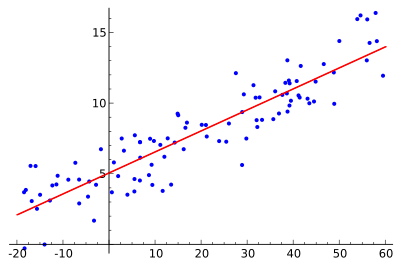

Ideja je najti rdečo krivuljo, modre točke pa so dejanski vzorci. Pri linearni regresiji lahko vse točke povežemo z eno samo ravno črto. V tem primeru je uporabljena preprosta linearna regresija, pri kateri je kvadrat razdalje med rdečo črto in vsako vzorčno točko minimiziran.

Uporaba

Ekonomija

Linearna regresija je glavno analitično orodje v ekonomiji. Uporablja se na primer za ocenjevanje potrošnje, investicij v osnovna sredstva, investicij v zaloge, nakupov izvoza države, izdatkov za uvoz, povpraševanja po likvidnih sredstvih, povpraševanja po delu in ponudbe dela.

Vprašanja in odgovori

V: Kaj je linearna regresija?

O: Linearna regresija je način matematičnega preučevanja, kako se nekaj spremeni, ko se spremenijo druge stvari. Uporablja odvisno spremenljivko in eno ali več pojasnjevalnih spremenljivk, da bi ustvarila ravno črto, znano kot "regresijska črta".

V: Katere so prednosti linearne regresije?

O: Modele, ki so linearno odvisni od svojih neznanih parametrov, je lažje prilagoditi kot modele, ki so nelinearno povezani s svojimi parametri. Poleg tega je lažje določiti statistične lastnosti dobljenih ocenjevalcev.

V: Katere so praktične uporabe linearne regresije?

O: Linearno regresijo lahko uporabimo za prileganje napovednega modela opazovanim vrednostim (podatkom), da bi naredili napovedi, napovedi ali redukcije. Uporablja se lahko tudi za količinsko opredelitev moči razmerij med spremenljivkami in za prepoznavanje podskupin podatkov, ki vsebujejo odvečne informacije o drugi spremenljivki.

V: Kako poskušajo linearni regresijski modeli zmanjšati napake?

O: Linearni regresijski modeli si prizadevajo, da bi bila navpična razdalja med premico in podatkovnimi točkami (ostanki) čim manjša. To se doseže z minimiziranjem vsote kvadratov ostankov (najmanjši kvadratki), pomanjkanja ujemanja v neki drugi normi (najmanjša absolutna odstopanja) ali z minimiziranjem penalizirane različice izgubne funkcije najmanjših kvadratov (regresija grebenov).

V: Ali je mogoče, da modeli linearne regresije ne temeljijo na metodi najmanjših kvadratov?

O: Da, možno je, da modeli linearne regresije ne temeljijo na metodi najmanjših kvadratov, ampak se namesto tega uporabljajo metode, kot sta minimizacija pomanjkanja ujemanja v neki drugi normi (najmanjša absolutna odstopanja) ali minimizacija kaznovane različice izgubne funkcije najmanjših kvadratov (regresija grebena).

V: Ali sta "linearni model" in "najmanjši kvadrat" sinonima?

O: Ne, nista sinonima. Čeprav sta tesno povezana, se "linearni model" nanaša predvsem na uporabo ravne črte, medtem ko se "najmanjši kvadrati" nanašajo predvsem na poskus zmanjšanja napak z zagotavljanjem minimalne navpične razdalje med črto in podatkovnimi točkami.

Iskati